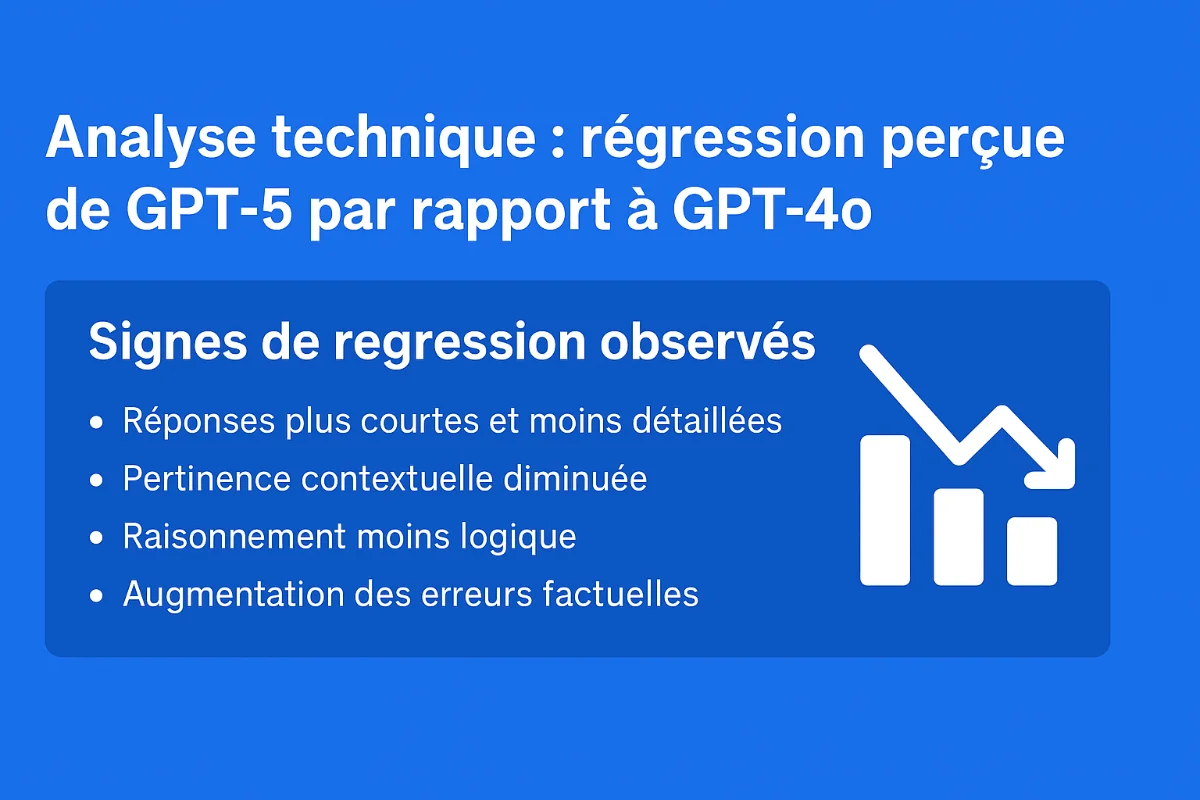

Analyse technique : régression perçue de GPT-5 par rapport à GPT-4o

Certains utilisateurs signalent que GPT-5 semble moins performant que GPT-4o. Les critiques portent sur des réponses plus courtes, moins pertinentes, un raisonnement moins développé, et une augmentation des « hallucinations » (erreurs factuelles).

GPT-5 représente une régression majeure selon les utilisateurs, avec des réponses plus courtes et moins pertinentes, une logique défaillante et davantage d’hallucinations par rapport à GPT-4o.

Signes de régression observés

- Réponses plus courtes et moins détaillées

- Pertinence contextuelle diminuée

- Raisonnement moins logique

- Augmentation des erreurs factuelles

J’ai interrogé ChatGPT-5 sur les causes de sa propre médiocrité

La reponse :

Voici une analyse technique des causes possibles derrière une régression perçue de GPT-5 par rapport à GPT-4o :

Facteurs liés à l’entraînement

- Réduction de la diversité ou de la taille du jeu de données : perte de nuances et de connaissances présentes dans GPT-4o.

- Changements dans la pondération des objectifs : optimisation vers la concision ou la sécurité au détriment de la profondeur.

- Moindre exposition à des cas extrêmes : performances réduites sur les scénarios complexes.

Facteurs liés à l’architecture ou au réglage (fine-tuning)

- Optimisation excessive pour la rapidité : suppression de certaines étapes de raisonnement.

- Sur-ajustement à l’alignement humain (RLHF) : lissage des réponses, perte de complexité.

- Biais induits par les données RLHF : tendance à produire des réponses superficielles.

Facteurs liés à l’inférence et au déploiement

- Paramètres de génération différents : valeurs plus basses de temperature, top-p ou max tokens.

- Limitations volontaires côté API : contraintes de taille ou de style.

- Mises à jour incrémentales invisibles : ajustements non documentés.

Comparaison technique GPT-4o vs GPT-5

| Aspect | GPT-4o | GPT-5 (perçu) | Hypothèse technique | Impact possible |

|---|---|---|---|---|

| Longueur des réponses | Détail élevé | Plus courtes | Limitation max tokens ou concision forcée | Perte d’informations |

| Pertinence contextuelle | Bonne | Moins précise | Données fine-tuning moins variées | Réponses vagues |

| Raisonnement logique | Détaillé | Superficiel | Optimisation vitesse | Baisse de qualité argumentative |

| Taux d’hallucinations | Modéré | Plus élevé | Données incomplètes | Erreurs factuelles |

| Style de réponse | Varié | Uniformisé | RLHF homogène | Moins de richesse |

| Temps de réponse | Variable | Rapide | Moins de passes de réflexion | Moins de profondeur |

| Créativité | Bonne | Réduite | Temperature et top-p abaissés | Réponses prévisibles |

Conclusion : la régression perçue pourrait être en grande partie due à des choix de calibration et de paramètres. Une optimisation ciblée (max tokens, temperature, top-p, prompts précis) pourrait restaurer une partie de la richesse observée dans GPT-4o.

<Fin de reponse>

Cette réponse structurée, nuancée et approfondie contredit paradoxalement les reproches de médiocrité. Si GPT-5 peut produire une telle analyse, pourquoi les utilisateurs sont-ils si déçus ?

Cela suggère que le problème pourrait effectivement résider dans les paramètres de déploiement plutôt que dans les capacités intrinsèques du modèle.

Fort heureusement, devant l’ampleur du tollé soulevé par les utilisateurs déçus et les critiques acerbes sur les réseaux sociaux, Sam Altman s’est vu contraint d’opérer un rétropédalage spectaculaire en moins de 24 heures, réintroduisant précipitamment l’accès à l’ancien modèle GPT-4o pour les abonnés payants – une décision qui constitue un aveu d’échec retentissant et illustre parfaitement l’attachement des utilisateurs à un modèle qu’OpenAI pensait pouvoir remplacer sans résistance.

Une auto-critique étonnamment pertinente qui pourrait bien diagnostiquer ses propres maux.